Overeenstemming over de AI Act

Het Europees Parlement, de Lidstaten en de Europese Commissie hebben overeenstemming bereikt over de tekst van de nieuwe AI verordening (AI Act).

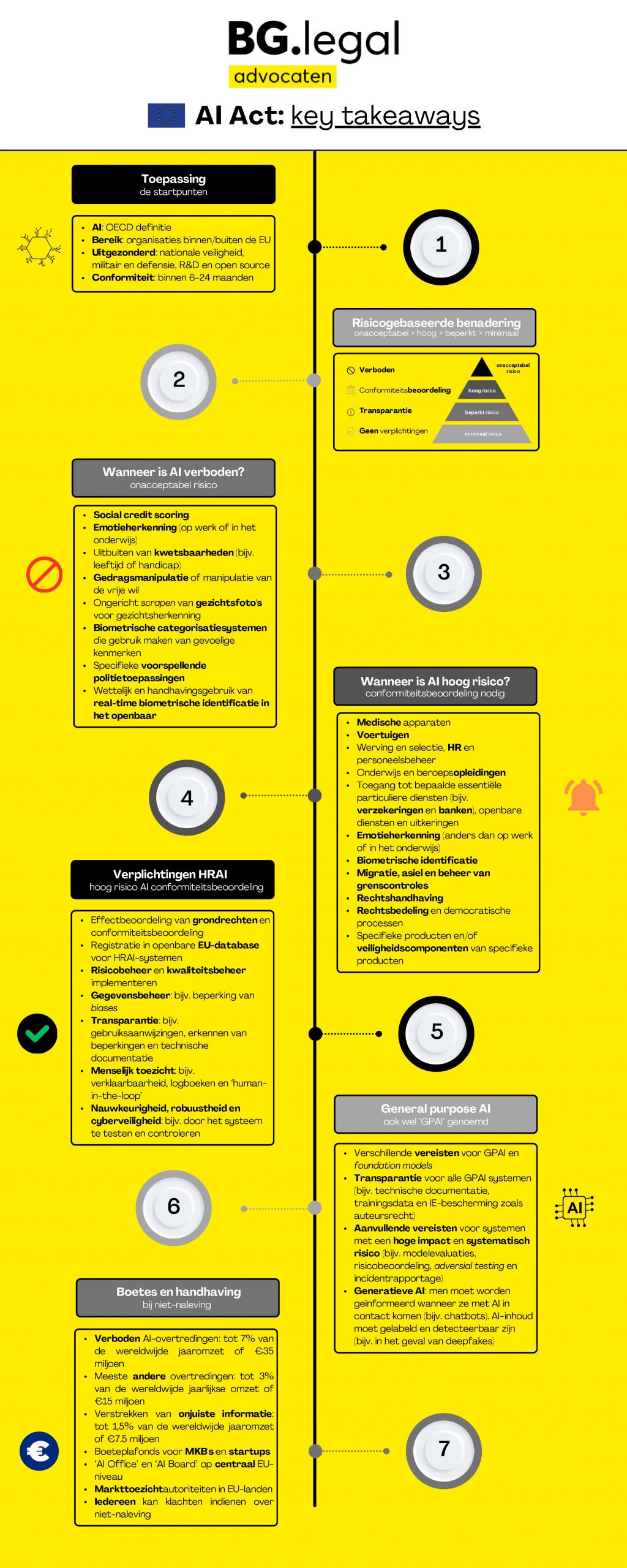

Wat staat er in de AI Act?

Verboden toepassingen

Een aantal AI toepassingen zijn verboden, zoals

- Het ongericht schrapen van gezichtsbeelden van internet of CCTV-beelden om gezichtsherkenningsdatabases te creëren. Dit omvat dus ook praktijken zoals die van Clearview AI.

- Emotieherkenning op de werkvloer en in onderwijsinstellingen. Met uitzonderingen zoals AI systemen die herkennen dat een chauffeur in slaap is gevallen.

- AI die wordt gebruikt om de kwetsbaarheden van mensen uit te buiten (vanwege hun leeftijd, handicap, sociale of economische situatie).

- AI systemen die op individuele basis het risico voorspellen op het in de toekomst plegen van misdaden (predictive policing software)

- Onder strikte voorwaarden wordt het toegestaan dat autoriteiten met realtime gezichtsherkenningssytemen in de publieke ruimte op zoek gaan naar personen. De lijst van misdrijven is groot en omvat terrorisme, mensenhandel, seksuele uitbuiting, moord, ontvoering, verkrachting, gewapende overval, deelname aan een criminele organisatie, milieucriminaliteit.

Hoog risico AI Act

AI systemen moeten worden ingedeeld in een risico-categorie. Dit zal de leverancier/ontwikkelaar moeten doen op basis van het beoogd gebruik. De AI systemen die als hoog-risico worden geclassificeerd staan op een bijlage bij de AI act. Voor deze AI systemen zal een mensenrechten Impact Assessment (IAMA) verplicht zijn. Deze verplichting geldt alleen voor overheidsinstanties en particuliere entiteiten die diensten van algemeen belang verlenen, zoals ziekenhuizen, scholen, banken en verzekeringsmaatschappijen.

De hoog-risico systemen moeten aan verplichtingen voldoen zoals een risico-management systeem, cyberveiligheid en menselijk toezicht.

Voor de meeste AI systemen zal gelden dat door ‘self-assessment’ moet worden vastgesteld:

- Of een AI systeem valt onder het bereik van de AI verordening

- In welke risico-categorie een AI systeem valt

- Of een AI systeem voldoet aan de vereisten van die risico-categorie.

BG.legal werkt in een consortium aangevoerd door LegalAIR, aan een AI Compliance Check. Daarbij maken we ‘vage’ normen toetsbaar en meetbaar. We volgen daarvoor het werk van de standaardisatie instanties die hier aan werken.

General purpose AI systems

Voor deze AI systemen, zoals ChatGPT, geldt dat zij transparant zullen moeten zijn over hoe zij voldoen aan de AI act. Dit omvat het verstrekken van technische documentatie, het respecteren van auteursrecht en het doen van een gedetailleerde opgave van al het materiaal dat is gebruikt voor het trainen van het model. En niet alleen door de provider van het GPAI systeem, maar ook door partijen die ergens in het ontwikkelproces hebben meegewerkt. Dus de hele keten.

AI regulatory sandbox

MKB bedrijven worden ondersteund bij de ontwikkeling van AI systemen die compliant zijn met de AI act. Overheden moeten daarvoor gaan werken met de AI regulatory sandbox. Dit is een afgesloten omgeving waarin (bepaalde aspecten van) een AI systeem, onder toezicht van een toezichthouder, getest kan worden. Een andere vorm is het “real-world-testing”. Noorwegen en de UK kennen dit instrument al. Hoe dit gaat werken moet nog concreet worden ingevuld. Zoals welke AI systemen in aanmerking komen, welke informatie moet worden gedeeld met de toezichthouder, welke informatie wordt later publiek gemaakt, is de toezichthouder bereid om constructief mee te denken om het AI systeem compliant te maken, etc.

Boetes

Aan het handelen in strijd met de AI act zijn hoge boetes verbonden. Er kunnen boetes worden opgelegd tot EUR 35 miljoen of 7% van de wereldwijde omzet.

Wanneer treedt de AI Act in werking?

De definitieve tekst zal nu vertaald moeten worden naar alle EU talen en worden aangenomen door het Europees Parlement. Vervolgens zal de AI Act in werking treden twee jaar na de datum van publicatie. Maar een aantal verplichtingen zal al een jaar eerder van kracht zijn. Zoals verplichtingen voor hoog-risico AI systemen, powerful AI models, de instanties die conformity assessments uitvoeren en het governance hoofdstuk.

Wat betekent dit in de tussentijd?

Het zou niet verstandig zijn om te wachten tot over twee jaar.

Wat zouden ontwikkelaars van AI systemen moeten doen:

- Van hun AI systeem beoordelen, op basis van het beoogd gebruik, in welke risico-categorie het AI systeem valt.

- Beoordelen of het AI systeem voldoet aan de vereisten van die risico-categorie.

- Wanneer discussie mogelijk is over de vraag of het een verboden of hoog-risico categorie AI systeem is, dit laten vaststellen door een derde partij (AI risk assessment).

- Wanneer het een hoog-risico AI systeem is, voorbereiden dat het compliant zal zijn met de vereisten die de AI act stelt.

- Wanneer onduidelijk is hoe de AI act uitgelegd moet worden voor jouw AI systeem, of een bepaald aspect daarvan, overweeg je te melden voor een

AI regulatory sandboxof voorreal-world-testing.

Wat zouden afnemers/gebruikers van AI systemen moeten doen:

- Inventariseer welke AI systemen je organisatie gebruikt. Vraag leveranciers van software of er AI is verwerkt in de software.

- Beoordeel vervolgens of AI systemen worden gebruikt die in de verboden of hoog-risico categorie vallen. Vraag zo nodig je leverancier van software om verklaringen/garanties dat er geen verboden en/of hoog-risico AI systemen worden ingezet.

- Wanneer je gebruik maakt van een verboden AI systeem, faseer dit uit. Ga op zoek naar alternatieven en beëindig het gebruik van dit AI systeem.

- Wanneer je gebruik maakt van een hoog-risico AI systeem, beoordeel of het AI systeem aan de vereisten voldoet. Daar waar het AI systeem niet aan een vereiste voldoet, zet een traject in gang om ervoor te zorgen dat het AI systeem aan de vereisten gaat voldoen. Leg deze verplichting zo mogelijk bij de leverancier van het AI systeem.

- Pas je inkoopvoorwaarden aan. Zorg dat een leverancier van hardware/software transparant is over de AI systemen die het wil gaan leveren en de risico-categorie waar het AI systeem in valt. Waarborg ook dat het AI systeem aan de vereisten blijft voldoen. De leverancier zou dit gedurende het gehele gebruik van het AI systeem moeten monitoren (post-market surveillance) en het AI systeem zo nodig aanpassen.

Hoe kunnen wij hierbij helpen?

Uitleg

Binnenkort komt de definitieve tekst beschikbaar van de AI act. Wij kunnen helpen bij de uitleg van de tekst. Wat wordt er bedoeld met ‘human oversight’? Wat valt wel of niet onder de definitie van Artificial Intelligence? Hoe ziet een self assessment eruit?

AI risk/impact assessment

Er zijn inmiddels verschillende assessments om de impact van een AI systeem in kaart te brengen. Per use-case, per sector kan een risk/impact assessment er anders uit zien. Zo zal een assessment voor een AI toepassing in de health sector er anders uit zien dan voor een AI toepassing in de vervoerssector. Wij kunnen helpen bij het vinden van een goed toepasbaar assessment. Wij kunnen dit ook helpen uitvoeren. Dat kunnen we doen via het LegalAIR consortium met partners die expert zijn op gebieden zoals data science, cyberveiligheid, data ethiek.

Impact Assessment Mensenrechten en Algoritme (IAMA)

Wij hebben ervaring met het uitvoeren van een IAMA. Een organisatie kan zelf een IAMA uitvoeren. De ervaring leert dat het handig is en efficiënter werkt wanneer een IAMA met een externe begeleider wordt uitgevoerd.

AI policy

Met de komst van AI tools zoals ChatGPT en Midjourney, is het gebruik van AI toegankelijker en gemakkelijker geworden. Maar wie beslist over welke AI tools gebruikt mogen worden? En heeft een organisatie interne spelregels voor het gebruik mogen maken van dergelijke AI tools? Vraagt inkoop om informatie/garanties over de werking/ontwikkeling/compliance van AI tools?

Deze onderwerpen komen aan de orde in een ‘AI policy’. Dit is een document dat we maatwerk maken voor organisaties zodat er verantwoord gebruik gemaakt kan worden van AI in de organisatie.

AI audit

Zoals een organisatie laat beoordelen of de bedrijfsvoering aan bepaalde ISO normen voldoet, zo kan een organisatie ook laten beoordelen of een AI systeem voldoet aan vereisten. Ook nu is er al wet- en regelgeving van toepassing op AI systemen. Denk aan privacy (AVG), mensenrechten (grondwet, Europees Handvest), mededinging, consumentenregelgeving, etc. Daar komt nu dus de AI act bij. Bij het in kaart brengen van risico’s verbonden aan een onderneming, hoort ook een onderzoek naar risico’s verbonden aan het gebruik van bepaalde AI systemen. Bijvoorbeeld in het kader van een due diligence bij een fusie/overname.

Wij bereiden organisaties voor op een AI audit, bijvoorbeeld een audit naar de auditregels van de non-profit organisatie ForHumanity. Jos van der Wijst is FH auditor.

Voor meer informatie: neem contact op met Jos van der Wijst (wijst@bg.legal).