Audit van AI systemen

Iedereen gebruikt dagelijks, bewust of onbewust, verschillende AI toepassingen. AI systemen kunnen veel goeds brengen. Zie bijvoorbeeld de mooie toepassingen in de zorg, mobiliteit en infrastructuur. Maar het gebruik van AI systemen kan ook tot schade leiden voor mensen of het kan mensenrechten schenden. Denk bijvoorbeeld aan de toeslagenaffaire.

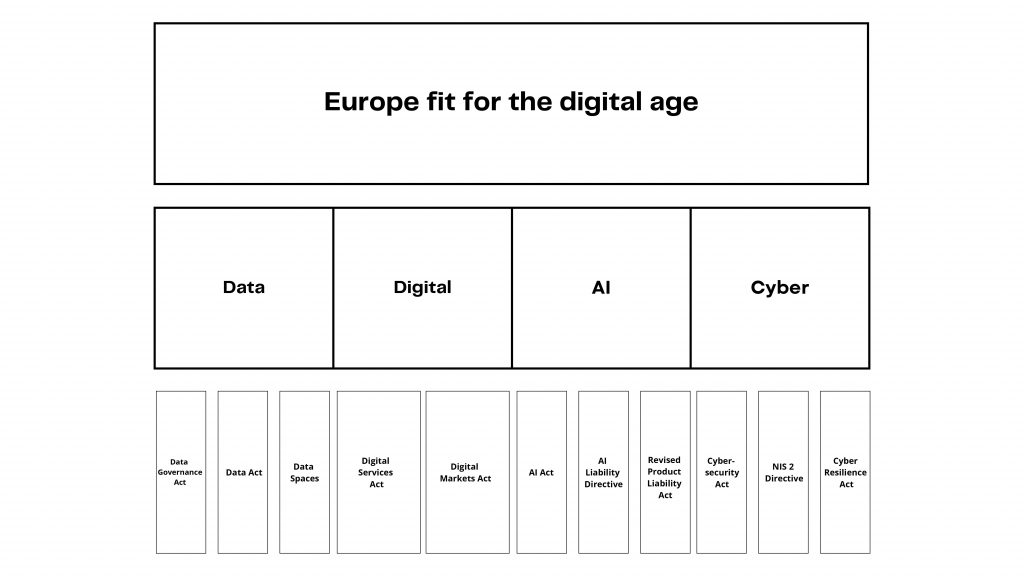

Er is al wet- en regelgeving waar AI systemen aan moeten voldoen. Denk bijvoorbeeld aan de grondwet, consumentenregelgeving en de AVG. Daarnaast is er ook sectorspecifieke regelgeving waar AI systemen aan moeten voldoen. En er komt uit Europa nog meer regelgeving die relevant is voor AI systemen, de data die AI systemen kunnen gebruiken en de aansprakelijkheid van (gebruikers van) AI systemen.

Een veel gehoorde vraag is: ‘Waar kan ik een ‘groen vinkje’ / ‘seal of approval’ krijgen voor mijn AI systeem? Dit was voor ons ook aanleiding voor het project ‘AI Compliance Check’.

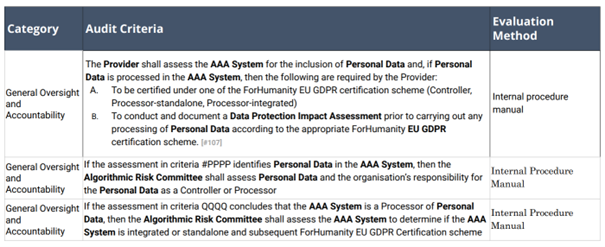

De vrijwilligers van de non-profit organisatie ForHumanity hebben audit criteria ontwikkeld voor AI systemen. Uitgangspunt van deze criteria zijn het beperken van risico’s van AI systemen op het gebied van ethiek, vooringenomenheid (BIAS), privacy, vertrouwen en cyberbeveiliging. Het is niet een ‘eenvoudige’ checklist. Het voldoen aan een audit criterium moet blijken uit gedocumenteerd bewijs. Bij een audit moet dit worden vastgesteld. Bijvoorbeeld:

(bron: ForHumanity)

Voor wie is een AI Audit zinvol?

Ontwikkelaar: wanneer jij een AI systeem hebt ontwikkeld, dan kun je vragen krijgen over het ‘compliant’ zijn met wet- en regelgeving. Vragen zoals: Voldoet dit AI systeem aan alle wettelijke vereisten? Wat voor risico loop ik wanneer ik dit AI systeem ga gebruiken? En is dit AI systeem voorbereid op de AI Act (AI verordening). En het voorbereid zijn op de komende AI Act. Met een audit laat je zien dat het AI systeem voldoet aan de audit criteria van ForHumanity. Dat is een waarborg dat het AI systeem compliant is op het gebied van ethiek, vooringenomenheid (BIAS), privacy, vertrouwen en cyberbeveiliging. Na een geslaagde audit krijg je een ‘certification report’ dat je kunt publiceren en/of naar toezichthouders kunt sturen. Dit draagt bij aan trust/vertrouwen in jouw AI systeem.Koper/gebruiker/distributeur: wanneer je een AI systeem wil gaan gebruiken dan wil je de risico’s die verband houden met dat AI systeem in kaart hebben gebracht. Dat zou kunnen met een AI risk assessment. Nog beter is het om de leverancier te vragen om een rapport van een succesvol afgeronde AI audit.

Wat doen wij?

Jos van der Wijst is een door ForHumanity gecertificeerde auditor van AI systemen. Met een team, bestaande uit medewerkers met een juridische en software/data science achtergrond, bereiden wij je voor op een audit van een AI systeem. Wij voeren uit:

- AI risk assessment

- Cybersecurity risk assessment

- AVG (GDPR) conformity assessment

- ForHumanity audit van AI systemen

Wil je hier meer over weten neem dan contact op met Jos van der Wijst (wijst@bg.legal).