Blog van medewerkers

Duur:lang genoeg om de klant in staat te stellen alternatieven te implementeren of interne continuïteit te waarborgen.Inhoud:toegang tot essentiële supportdiensten zoals beveiligingsupdates, bugfixes, technische documentatie en exportfunctionaliteit.Tarief:marktconform en transparant, aansluitend bij eerdere contractvoorwaarden.Overdracht:actieve ondersteuning bij kennisoverdracht en systeemmigratie.

Waarom deze uitspraak ertoe doet

De uitspraak is relevant voor beide kanten van de contractuele tafel: Voor afnemers:Bescherming tegen vendor lock-in:bedrijven en overheden die afhankelijk zijn van specifieke software kunnen nu juridisch afdwingen dat ze niet plotseling worden afgesneden.Versterkte onderhandelingspositie:afnemers hebben een argument in handen om bij het sluiten van een contract al afspraken te maken over exitondersteuning.

Nieuwe zorgplicht:het enkele aflopen van een contract is geen vrijbrief meer om support te staken – zeker niet bij langdurige afhankelijkheid.Exitplan als contractonderdeel:leveranciers doen er verstandig aan om standaard (redelijke) exitvoorwaarden op te nemen in SLA’s en algemene voorwaarden.

Praktische tips voor IT-contracten

Deze zaak benadrukt het belang van een goed doordachte exitstrategie, zowel voor afnemers als leveranciers.- Breng afhankelijkheden in kaart: technisch, functioneel en operationeel.

- Leg exit-afspraken contractueel vast: hoe lang duurt support na beëindiging, wat zijn de kosten, welke dienstverlening wordt geleverd?

- Houd rekening met budget en implementatietijd van alternatieven.

- Ontwikkel standaard exitprotocollen en neem deze op in contractdocumentatie.

- Wees vooraf transparant over kostenstructuur voor exitondersteuning.

- Vermijd een juridisch zwakke positie door tijdig het gesprek aan te gaan over de exitfase.

Toekomstbestendig contracteren

De uitspraak in de zaak RWS/Broadcom markeert een belangrijke ontwikkeling in [post_title] => Leveranciersverantwoordelijkheid bij IT-exit: lessen uit de VMware-uitspraak

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => leveranciersverantwoordelijkheid-bij-it-exit-lessen-uit-de-vmware-uitspraak

[to_ping] =>

[pinged] =>

[post_modified] => 2025-06-30 14:50:20

[post_modified_gmt] => 2025-06-30 12:50:20

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=45238

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[3] => WP_Post Object

(

[ID] => 44922

[post_author] => 6

[post_date] => 2025-05-01 14:01:25

[post_date_gmt] => 2025-05-01 12:01:25

[post_content] => In de recente uitspraak van de Rechtbank Overijssel (ECLI:NL:RBOVE:2025:2459[1]) staat een geschil centraal tussen een IT-dienstverlener en een klant over de oplevering van software. De klant had de overeenkomst buitengerechtelijk ontbonden vanwege ontevredenheid over de voortgang en kwaliteit van het project. De IT-leverancier stelde dat er geen sprake was van een formele ingebrekestelling en dat de opzegging dus ongerechtvaardigd was. De rechtbank oordeelde echter dat er geen sprake was van “fatale termijnen” en geen sprake van een ontbindingbrief die aan de vereisten van een ingebrekestelling voldeed. En dus was er geen sprake van een ontbinding van de overeenkomst.

[post_title] => Leveranciersverantwoordelijkheid bij IT-exit: lessen uit de VMware-uitspraak

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => leveranciersverantwoordelijkheid-bij-it-exit-lessen-uit-de-vmware-uitspraak

[to_ping] =>

[pinged] =>

[post_modified] => 2025-06-30 14:50:20

[post_modified_gmt] => 2025-06-30 12:50:20

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=45238

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[3] => WP_Post Object

(

[ID] => 44922

[post_author] => 6

[post_date] => 2025-05-01 14:01:25

[post_date_gmt] => 2025-05-01 12:01:25

[post_content] => In de recente uitspraak van de Rechtbank Overijssel (ECLI:NL:RBOVE:2025:2459[1]) staat een geschil centraal tussen een IT-dienstverlener en een klant over de oplevering van software. De klant had de overeenkomst buitengerechtelijk ontbonden vanwege ontevredenheid over de voortgang en kwaliteit van het project. De IT-leverancier stelde dat er geen sprake was van een formele ingebrekestelling en dat de opzegging dus ongerechtvaardigd was. De rechtbank oordeelde echter dat er geen sprake was van “fatale termijnen” en geen sprake van een ontbindingbrief die aan de vereisten van een ingebrekestelling voldeed. En dus was er geen sprake van een ontbinding van de overeenkomst.

Wat betekent dit voor IT-bedrijven? Hierbij praktische tips voor IT-bedrijven

Toch benadrukt deze uitspraak wederom het belang voor IT-dienstverleners om alert te zijn op signalen van ontevredenheid bij klanten. Een opzegging of klacht kan, afhankelijk van de omstandigheden en formulering, juridisch worden opgevat als een ingebrekestelling. Dit heeft gevolgen voor de aansprakelijkheid en verplichtingen van de dienstverlener. Maar in dit geval was geen sprake van “fatale termijnen” en geen sprake van een “formele ingebrekestelling”.1. Formuleer termijnen zorgvuldig

Vermijd het gebruik van termen als "oplevering op 1 juni 2025" zonder nuance. Gebruik in plaats daarvan formuleringen zoals "streefdatum", "indicatieve planning" of "onder voorbehoud van tijdige aanlevering van benodigde informatie door de opdrachtgever". Dit voorkomt dat een termijn als fataal wordt beschouwd, wat kan leiden tot juridische gevolgen bij overschrijding van deze termijn.

2. Wees alert op signalen van ontevredenheid

Een e-mail of brief waarin de klant zijn ontevredenheid uit over de voortgang of kwaliteit van het project kan juridisch worden opgevat als een ingebrekestelling. Maar dat geldt niet zomaar. Neem dergelijke signalen serieus en reageer proactief om verdere escalatie te voorkomen. Zorg dat je kunt blijven aantonen dat je aan je inspanningsverplichting voldoet (bv plan van aanpak).

3. Documenteer communicatie zorgvuldig

Houd een gedetailleerd logboek bij van alle communicatie met de klant, vooral wanneer er klachten of opmerkingen over de dienstverlening zijn. Dit kan van cruciaal belang zijn bij een eventueel juridisch geschil. Zorg ook dat op klachten gereageerd wordt. Beter aangeven dat aan een oplossing wordt gewerkt dan niet reageren.

4. Stel duidelijke algemene voorwaarden op

Zorg ervoor dat uw algemene voorwaarden helder zijn over procedures bij klachten, termijnen en de gevolgen van niet-nakoming. Dit biedt houvast bij conflicten en kan juridische risico's beperken. Daarvoor zouden de NL Digital 2020 voorwaarden gebruikt kunnen worden.

5. Raadpleeg tijdig juridisch advies

Bij twijfel over de juridische implicaties van een klacht of opzegging is het raadzaam om juridisch advies in te winnen. Een advocaat kan helpen bij het beoordelen van de situatie en adviseren over de te nemen stappen. Wij bekijken dit ook met het oog op een mogelijke juridische procedure.

Door proactief te handelen en duidelijke afspraken te maken, kunnen IT-bedrijven juridische geschillen voorkomen en de klanttevredenheid behouden. En wanneer het toch tot een juridische procedure zou komen (rechtbank of arbitrage) dan zorgen wij dat het dossier optimaal is.

Heeft u hierover vragen? Neem dan contact met ons op of meld je aan voor de in-house workshop via deze link.

[1] ECLI:NL:RBOVE:2025:2459, Rechtbank Overijssel, C/08/314628 / HA ZA 24-206

[post_title] => Klachten, fatale termijnen en juridische gevolgen: lessen voor IT-leveranciers

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => klachten-fatale-termijnen-en-juridische-gevolgen-lessen-voor-it-leveranciers

[to_ping] =>

[pinged] =>

[post_modified] => 2025-05-06 11:41:04

[post_modified_gmt] => 2025-05-06 09:41:04

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=44922

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[4] => WP_Post Object

(

[ID] => 44695

[post_author] => 6

[post_date] => 2025-02-27 09:40:15

[post_date_gmt] => 2025-02-27 08:40:15

[post_content] => De Europese Unie introduceert nieuwe digitaliseringsregels die de manier waarop organisaties data verzamelen, delen en gebruiken ingrijpend veranderen. De

[post_title] => Klachten, fatale termijnen en juridische gevolgen: lessen voor IT-leveranciers

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => klachten-fatale-termijnen-en-juridische-gevolgen-lessen-voor-it-leveranciers

[to_ping] =>

[pinged] =>

[post_modified] => 2025-05-06 11:41:04

[post_modified_gmt] => 2025-05-06 09:41:04

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=44922

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[4] => WP_Post Object

(

[ID] => 44695

[post_author] => 6

[post_date] => 2025-02-27 09:40:15

[post_date_gmt] => 2025-02-27 08:40:15

[post_content] => De Europese Unie introduceert nieuwe digitaliseringsregels die de manier waarop organisaties data verzamelen, delen en gebruiken ingrijpend veranderen. De

Wat verandert er?

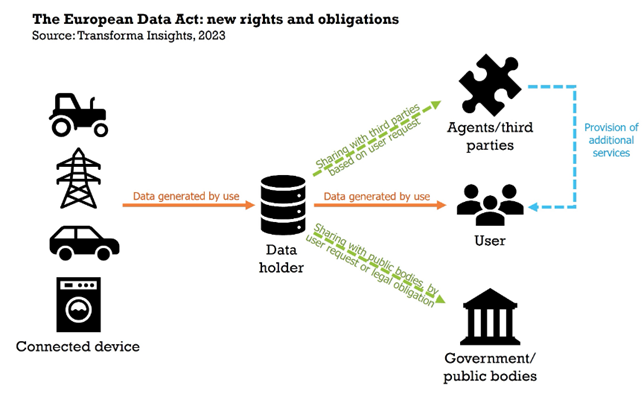

De EU Data Act introduceert:Data-deling verplichtingen:Organisaties moeten data transparant delen, vooral als deze afkomstig is van verbonden apparaten (apparaten verbonden met het internet).Beveiligings- en privacy-eisen:Strengere regels voor data-opslag en verwerking, vooral bij het werken met cloud providers buiten de EU.Concurrentiebevordering:Voorkomen van data-monopolies en bevorderen van eerlijke toegang tot data.

Wat betekent dit voor uw organisatie?

Voor datagebruikers:U moet nagaan of uw dataverwerkingsprocessen voldoen aan de nieuwe eisen. Het delen van data wordt verplicht, wat kan leiden tot nieuwe zakelijke kansen, maar ook tot grotere nalevingsverplichtingen.Voor softwareontwikkelaars:Uw tools moeten voldoen aan nieuwe interoperabiliteits- en beveiligingsnormen. Dit vraagt om updates en mogelijk herontwerp van bestaande software.

Wat is nieuw?

De Europese Commissie heeft haar FAQ vernieuwd. Op een aantal onderdelen is nieuwe verduidelijking toegevoegd. We wachten nog steeds opWat te doen?

Wilt u weten hoe deze regelgeving uw organisatie beïnvloedt en welke stappen nodig zijn om [post_title] => Impact van EU digitaliseringsregelgeving op data gedreven organisaties

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => impact-van-eu-digitaliseringsregelgeving-op-data-gedreven-organisaties

[to_ping] =>

[pinged] =>

[post_modified] => 2025-02-27 09:41:57

[post_modified_gmt] => 2025-02-27 08:41:57

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=44695

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[5] => WP_Post Object

(

[ID] => 44611

[post_author] => 6

[post_date] => 2025-02-26 11:09:04

[post_date_gmt] => 2025-02-26 10:09:04

[post_content] => De Europese Commissie heeft recent

[post_title] => Impact van EU digitaliseringsregelgeving op data gedreven organisaties

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => impact-van-eu-digitaliseringsregelgeving-op-data-gedreven-organisaties

[to_ping] =>

[pinged] =>

[post_modified] => 2025-02-27 09:41:57

[post_modified_gmt] => 2025-02-27 08:41:57

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=44695

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[5] => WP_Post Object

(

[ID] => 44611

[post_author] => 6

[post_date] => 2025-02-26 11:09:04

[post_date_gmt] => 2025-02-26 10:09:04

[post_content] => De Europese Commissie heeft recent AI-Definitie: Wat valt eronder?

De nieuwe richtlijnen verduidelijken dat eenVerboden AI-praktijken

Sinds 2 februari 2025 zijn bepaalde AI-toepassingen in de EU verboden omdat ze onaanvaardbare risico’s vormen voor de maatschappij. Voorbeelden hiervan zijn:Sociale scoring: AI-systemen die individuen rangschikken op basis van sociaal gedrag of persoonlijke kenmerken.Manipulatieve technieken:AI die psychologische technieken gebruikt om menselijk gedrag te beïnvloeden, zoals deepfake-technologieën en verslavingsmechanismen in sociale media.Biometrische surveillance:In de meeste gevallen is real-time biometrische surveillance in openbare ruimtes verboden.

Wat betekent dit voor uw organisatie?

Voor AI-ontwikkelaars:Het is cruciaal om uw AI-systemen te evalueren aan de hand van de nieuwe definitie. Als uw toepassing als AI-systeem wordt geclassificeerd, moet deze voldoen aan de AI Act, inclusief transparantie- en veiligheidsvereisten.Voor AI-gebruikers:Controleer of de AI-tools die u inzet compliant zijn met de AI Act en dat verboden toepassingen niet in uw processen zijn geïntegreerd.Voor investeerders in AI:Beoordeel investeringsmogelijkheden kritisch op compliance met de AI Act om juridische en financiële risico's te vermijden.

Wat te doen?

Wilt u weten of uw AI-systemen onder de nieuwe definitie vallen of voldoen aan de regels voor verboden AI-praktijken? BG.legal helpt u graag bij compliance-checks, AI policy/AI governance documenten en strategisch advies. Voor complexe AI vraagstukken werken wij samen met experts in het LegalAIR verband. Daar werken we samen met partner op het gebied van ethiek, techniek en cybersecurity. Neem vandaag nog contact met ons op om uw [post_title] => Nieuwe EU-richtlijnen over AI-definitie en verboden AI-praktijken

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => nieuwe-eu-richtlijnen-over-ai-definitie-en-verboden-ai-praktijken

[to_ping] =>

[pinged] =>

[post_modified] => 2025-02-26 11:09:04

[post_modified_gmt] => 2025-02-26 10:09:04

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=44611

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[6] => WP_Post Object

(

[ID] => 44050

[post_author] => 6

[post_date] => 2024-11-18 13:48:12

[post_date_gmt] => 2024-11-18 12:48:12

[post_content] => Een gemeente gaat, na een aanbesteding, een dienst afnemen waarbij AI wordt gebruikt door de leverancier. De gemeente wil zeker weten dat deze dienst wet- en regelgeving nakomt. Met name

[post_title] => Nieuwe EU-richtlijnen over AI-definitie en verboden AI-praktijken

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => nieuwe-eu-richtlijnen-over-ai-definitie-en-verboden-ai-praktijken

[to_ping] =>

[pinged] =>

[post_modified] => 2025-02-26 11:09:04

[post_modified_gmt] => 2025-02-26 10:09:04

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=44611

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[6] => WP_Post Object

(

[ID] => 44050

[post_author] => 6

[post_date] => 2024-11-18 13:48:12

[post_date_gmt] => 2024-11-18 12:48:12

[post_content] => Een gemeente gaat, na een aanbesteding, een dienst afnemen waarbij AI wordt gebruikt door de leverancier. De gemeente wil zeker weten dat deze dienst wet- en regelgeving nakomt. Met name - Wordt hier een AI techniek gebruikt waardoor het voldoet aan de definitie van Artificial Intelligence in de AI Act.

- Zo ja, in welke risico categorie van de AI Act, valt dit AI-systeem.

- De AI Act onderscheidt verschillende rollen van partijen in de keten (ontwikkelaar, verkoper, gebruiker). Wie vervult welke rol en voldoet deze partij aan de verplichtingen van die rol.

[post_title] => AI Act compliance

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => ai-act-compliance

[to_ping] =>

[pinged] =>

[post_modified] => 2024-11-18 14:00:28

[post_modified_gmt] => 2024-11-18 13:00:28

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=44050

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[7] => WP_Post Object

(

[ID] => 43637

[post_author] => 6

[post_date] => 2024-09-19 11:17:00

[post_date_gmt] => 2024-09-19 09:17:00

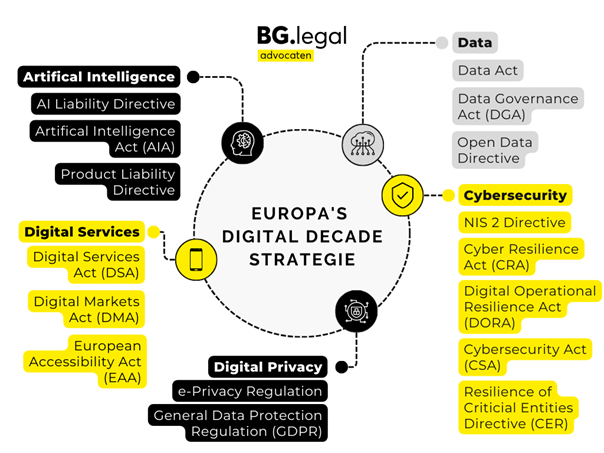

[post_content] => De Europese Unie wil met haar digitale strategie ervoor zorgen dat zowel mensen als bedrijven optimaal profiteren van de digitale technologie die ons leven ingrijpend verandert. Deze strategie omvat meer dan honderd verschillende soorten wet- en regelgeving, die nieuw zijn, herzien of al bestaan. Deze regels hebben impact op vrijwel elke sector en elk bedrijf binnen de EU. Bedrijven ontkomen tegenwoordig niet meer aan onderwerpen zoals privacy en cybersecurity. Hieronder volgt een kort overzicht van de meest relevante regelgeving in het kader van de ‘

[post_title] => AI Act compliance

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => ai-act-compliance

[to_ping] =>

[pinged] =>

[post_modified] => 2024-11-18 14:00:28

[post_modified_gmt] => 2024-11-18 13:00:28

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=44050

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[7] => WP_Post Object

(

[ID] => 43637

[post_author] => 6

[post_date] => 2024-09-19 11:17:00

[post_date_gmt] => 2024-09-19 09:17:00

[post_content] => De Europese Unie wil met haar digitale strategie ervoor zorgen dat zowel mensen als bedrijven optimaal profiteren van de digitale technologie die ons leven ingrijpend verandert. Deze strategie omvat meer dan honderd verschillende soorten wet- en regelgeving, die nieuw zijn, herzien of al bestaan. Deze regels hebben impact op vrijwel elke sector en elk bedrijf binnen de EU. Bedrijven ontkomen tegenwoordig niet meer aan onderwerpen zoals privacy en cybersecurity. Hieronder volgt een kort overzicht van de meest relevante regelgeving in het kader van de ‘

Artificial Intelligence Act (AIA)

- Kern: Reguleert

AI-systemendoor risico’s te beoordelen van ‘minimaal risico’ tot ‘onaanvaardbaar risico’. Strenge regels voor hoog-risico toepassingen zoals gezichtsherkenning en medische apparaten. - Doelgroep: Ontwikkelaars, verkopers, importeurs en gebruikers van AI-systemen in sectoren zoals gezondheidszorg, transport en overheid.

- Status: Van kracht sinds 2 augustus 2024. Gefaseerde verplichtingen: 6 maanden (verboden systemen), 12 maanden (GPAI), 24 maanden (hoog-risico Annex III).

Digital Services Act (DSA)

- Kern: Zorgt voor een veiligere online omgeving door platformen verantwoordelijk te houden voor schadelijke inhoud en reguleert online marktplaatsen.

- Doelgroep:

Online platformen(zoals sociale media en e-commerce websites) en consumenten. - Status: Van kracht sinds 16 november 2022. Voor ‘erg grote platformen’ en zoekmachines al langer van kracht. Voor kleinere platformen sinds 17 februari 2024.

European Accessibility Act

- Kern: Stelt eisen aan de toegankelijkheid van producten en diensten (zoals smartphones, websites, geldautomaten en e-commerce) voor mensen met een handicap.

- Doelgroep: Bedrijven die digitale producten en diensten aanbieden en gebruikers met een handicap.

- Status: Van kracht sinds juni 2022.

Nationale wetgevinguiterlijk aan te passen op 28 juni 2025.

Data Act

- Kern: Bevordert eerlijke toegang tot en gebruik van (vooral niet-persoonlijke) data, tussen bedrijven en overheden, wat innovatie stimuleert.

- Doelgroep: Bedrijven die

data verzamelen, delen of gebruiken, evenals overheden en consumenten. - Status: Van kracht sinds 11 januari 2024. Verplichtingen van kracht vanaf 12 september 2025.

NIS2 Directive

- Kern: Verbetering van de

cyberveiligheidin essentiële sectoren door striktere beveiligingsvereisten voor bedrijven en overheidsinstanties. - Doelgroep: Kritieke infrastructuursectoren zoals energie, transport, gezondheidszorg en digitale dienstverleners.

- Status: Van kracht sinds 16 januari 2023. Om te zetten in nationale regelgeving voor 18 oktober 2024. Op dit moment is van de Cyberveiligheidswet alleen een ontwerptekst beschikbaar.

General Data Protection Regulation (GDPR) (in Nederland bekend als de AVG)

- Kern: Beschermt

persoonsgegevensmet strenge regels over het verzamelen, verwerken en bewaren van data binnen de EU. - Doelgroep: Alle organisaties die persoonsgegevens verwerken, waaronder bedrijven, overheden en non-profitorganisaties.

- Status: Van kracht sinds 2018.

Data Governance Act

- Kern: Creëert een raamwerk voor datadeling en -beheer, gericht op het verbeteren van transparantie en vertrouwen in

data-uitwisselingssystemen. - Doelgroep: Overheidsinstanties, bedrijven en data-bemiddelingsdiensten.

- Status: Van kracht sinds 2023.

Open Data Directive

- Kern: Stimuleert innovatie en

economische groeidoor overheidsdata open te stellen voor hergebruik. - Doelgroep: Overheden, publieke instellingen en bedrijven die overheidsdata gebruiken.

- Status: Van kracht sinds 2021 en in Nederland omgezet in de Wet Open Overheid.

Product Liability Directive

- Kern: Richt zich op de aansprakelijkheid van producenten voor schade door gebrekkige producten, met speciale aandacht voor

technologische ontwikkelingenzoals slimme producten en AI. - Doelgroep: Fabrikanten van consumentengoederen, inclusief AI-gedreven producten.

- Status: Voorstel voor herziening gepresenteerd in september 2022, de onderhandelingen lopen nog.

- AI Liability Directive;

- Cybersecurity Act (CSA);

- Cyber Resilience Act (CRA);

- Digital Operational Resilience Act (DORA);

- Digital Markets Act (DMA);

- E-Privacy Regulation; en

- Resilience of Critical Entities Directive (CER).

[post_title] => Digital decade-regelgeving raakt ieder bedrijf

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => digital-decade-regelgeving-raakt-ieder-bedrijf

[to_ping] =>

[pinged] =>

[post_modified] => 2025-02-17 14:29:30

[post_modified_gmt] => 2025-02-17 13:29:30

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=43637

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[8] => WP_Post Object

(

[ID] => 43226

[post_author] => 6

[post_date] => 2024-08-21 12:05:13

[post_date_gmt] => 2024-08-21 10:05:13

[post_content] => Contracten voor

[post_title] => Digital decade-regelgeving raakt ieder bedrijf

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => digital-decade-regelgeving-raakt-ieder-bedrijf

[to_ping] =>

[pinged] =>

[post_modified] => 2025-02-17 14:29:30

[post_modified_gmt] => 2025-02-17 13:29:30

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=43637

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[8] => WP_Post Object

(

[ID] => 43226

[post_author] => 6

[post_date] => 2024-08-21 12:05:13

[post_date_gmt] => 2024-08-21 10:05:13

[post_content] => Contracten voor Standard contractual clauses

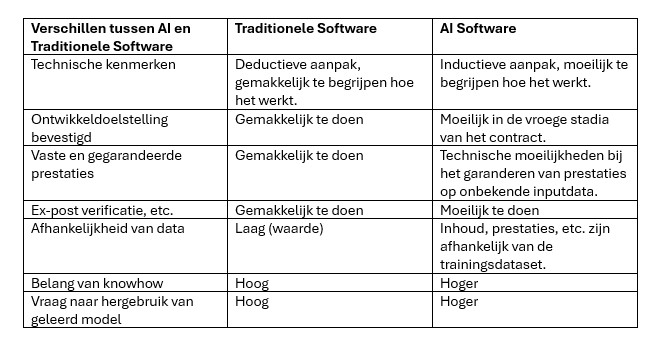

Een voorbeeld van een dergelijk contract is het “standard contractual clauses for the procurement ofVerschillen tussen AI en traditionele software

Een van de belangrijkste technische kenmerken vanVerschillen op een rijtje

Verschillende ontwikkelproces AI en software

Het ontwikkelproces van

Conclusie

In het licht van deze unieke kenmerken van AI-software, is het belangrijk dat contracten voor AI-toepassingen zorgvuldig worden opgesteld om rekening te houden met deze complexe kwesties. Dit kan helpen om duidelijkheid te scheppen over de rechten en verantwoordelijkheden van de betrokken partijen en om geschillen te voorkomen. Wil je een contract met betrekking tot de ontwikkeling of aankoop van een AI-toepassing laten opstellen of beoordelen, neem dan contact op met mij.Whitepaper

Wij hebben een whitepaper opgesteld met tips voor contacten met betrekking tot [post_title] => Waarom een contract voor het ontwikkelen/kopen van AI toepassingen geen standaard software contract is?

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => waarom-een-contract-voor-het-ontwikkelen-kopen-van-ai-toepassingen-geen-standaard-software-contract-is

[to_ping] =>

[pinged] =>

[post_modified] => 2024-08-27 11:12:56

[post_modified_gmt] => 2024-08-27 09:12:56

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=43226

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[9] => WP_Post Object

(

[ID] => 42982

[post_author] => 6

[post_date] => 2024-07-29 12:04:16

[post_date_gmt] => 2024-07-29 10:04:16

[post_content] => De vormgeving van een gebruiksvoorwerp kan auteursrechtelijk beschermd zijn. Dus ook van bijvoorbeeld

[post_title] => Waarom een contract voor het ontwikkelen/kopen van AI toepassingen geen standaard software contract is?

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => waarom-een-contract-voor-het-ontwikkelen-kopen-van-ai-toepassingen-geen-standaard-software-contract-is

[to_ping] =>

[pinged] =>

[post_modified] => 2024-08-27 11:12:56

[post_modified_gmt] => 2024-08-27 09:12:56

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=43226

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[9] => WP_Post Object

(

[ID] => 42982

[post_author] => 6

[post_date] => 2024-07-29 12:04:16

[post_date_gmt] => 2024-07-29 10:04:16

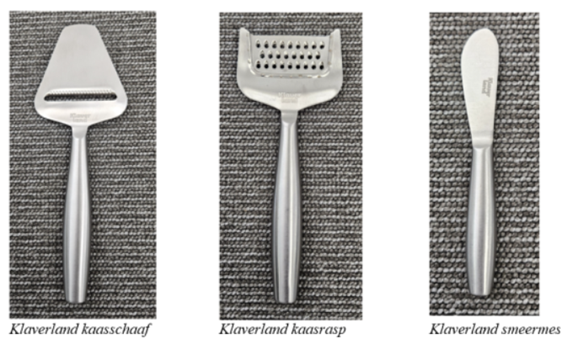

[post_content] => De vormgeving van een gebruiksvoorwerp kan auteursrechtelijk beschermd zijn. Dus ook van bijvoorbeeld  In 2023 eindigt de samenwerking. PLUS vraagt een andere partij om een kaasschaaf, kaasrasp en smeermes te leveren. Deze partij doet dit onder de naam Klaverland.

In 2023 eindigt de samenwerking. PLUS vraagt een andere partij om een kaasschaaf, kaasrasp en smeermes te leveren. Deze partij doet dit onder de naam Klaverland.

Boska stelt dat haar

Boska stelt dat haar Auteursrechtelijke bescherming

Aan een werk wordenSlaafse nabootsing

Voor- Vormgeving van gebruiksvoorwerpen kan auteursrechtelijk beschermd zijn maar de drempel lijkt hoog te zijn;

- Wanneer je auteursrechtelijke bescherming wilt onderbouwen, dan moet je tijdens het design proces zorgen voor een goede dossiervorming (wat is het vormgevingserfgoed, waar wijkt het nieuwe ontwerp af, wat zijn de vrije en creatieve keuzes die daarbij zijn gemaakt.

- Voor concurrenten kan dit ook kansen betekenen. Gebruiksvoorwerpen die niet aan de werktoets voldoen en die geen eigen plaats in de markt hebben, zijn vrij te kopiëren.

[post_title] => BOSKA kaasschaaf niet auteursrechtelijk beschermd

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => boska-kaasschaaf-niet-auteursrechtelijk-beschermd

[to_ping] =>

[pinged] =>

[post_modified] => 2024-07-29 12:04:16

[post_modified_gmt] => 2024-07-29 10:04:16

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=42982

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

)

[post_count] => 10

[current_post] => -1

[before_loop] => 1

[in_the_loop] =>

[post] => WP_Post Object

(

[ID] => 45384

[post_author] => 6

[post_date] => 2025-08-01 15:34:12

[post_date_gmt] => 2025-08-01 13:34:12

[post_content] => IT-juristen weten het al jaren:

[post_title] => BOSKA kaasschaaf niet auteursrechtelijk beschermd

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => boska-kaasschaaf-niet-auteursrechtelijk-beschermd

[to_ping] =>

[pinged] =>

[post_modified] => 2024-07-29 12:04:16

[post_modified_gmt] => 2024-07-29 10:04:16

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=42982

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

)

[post_count] => 10

[current_post] => -1

[before_loop] => 1

[in_the_loop] =>

[post] => WP_Post Object

(

[ID] => 45384

[post_author] => 6

[post_date] => 2025-08-01 15:34:12

[post_date_gmt] => 2025-08-01 13:34:12

[post_content] => IT-juristen weten het al jaren: De uitdaging: juridisch kaderen van agile/scrum

In deze zaak draait het om de ontwikkeling van een front-end via een agile/scrum-aanpak, met levering in sprints en een "definition of done". Triple IT factureerde voor haar werkzaamheden, terwijl On Air betaling weigerde, stellende dat niet aan de afgesproken voorwaarden was voldaan. Volgens On Air was geen sprake van deugdelijke oplevering, laat staan acceptatie. Het hof constateert echter dat het simpelweg ontbreken van een concrete opleverdatum — een typisch kenmerk van agile werken — het juridisch kader bemoeilijkt. Wat betekent ‘oplevering’ binnen agile? Is het label ‘done’ inDeskundige moet terminologie en praktijk uitleggen

In het tussenarrest van april 2024[1] besluit het hof dan ook om eenTraagheid en kosten van de procedure

De rechtbank deed uitspraak in maart 2022. Pas in april 2024 besluit het hof tot een deskundigenonderzoek. In juli 2025[2] wordt de deskundige officieel benoemd. De verwachting is dat het rapport pas in of na december 2025 beschikbaar komt, waarna partijen mogen reageren. Een einduitspraak? Niet eerder dan medio 2026. Een slepende hoger beroep procedure van vier jaar is dan een feit.Had dit beter gekund? Ja: arbitrage en duidelijke contracten

Een geschil als dit illustreert waarom partijen inConclusie

Deze zaak laat zien dat juridische systemen nog steeds moeite hebben om wendbare ontwikkelmethoden juridisch te duiden. Een deskundige moet nu de rechter helpen om agile te begrijpen. Maar had dit voorkomen kunnen worden? Absoluut, met duidelijke definities, goede documentatie, betere communicatie met de opdrachtgever en waar nodig een alternatieve geschilbeslechting via arbitrage c.q. bindend advies. Heb je hier vragen over? Neem dan contact op met Jos van der Wijst. [1] Gerechtshof Amsterdam, 23 april 2024, ECLI:NL:GHAMS:2024:1070 [2] Gerechtshof Amsterdam, 15 juli 2025, ECLI:NL:GHAMS:2025:1814 [post_title] => Agile, sprints en ‘done’ in de rechtszaal: Waarom rechters IT-deskundigen nodig hebben

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => agile-sprints-en-done-in-de-rechtszaal-waarom-rechters-it-deskundigen-nodig-hebben

[to_ping] =>

[pinged] =>

[post_modified] => 2025-08-01 15:34:12

[post_modified_gmt] => 2025-08-01 13:34:12

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=45384

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[comment_count] => 0

[current_comment] => -1

[found_posts] => 268

[max_num_pages] => 27

[max_num_comment_pages] => 0

[is_single] =>

[is_preview] =>

[is_page] =>

[is_archive] => 1

[is_date] =>

[is_year] =>

[is_month] =>

[is_day] =>

[is_time] =>

[is_author] =>

[is_category] =>

[is_tag] =>

[is_tax] => 1

[is_search] =>

[is_feed] =>

[is_comment_feed] =>

[is_trackback] =>

[is_home] =>

[is_privacy_policy] =>

[is_404] =>

[is_embed] =>

[is_paged] =>

[is_admin] =>

[is_attachment] =>

[is_singular] =>

[is_robots] =>

[is_favicon] =>

[is_posts_page] =>

[is_post_type_archive] =>

[query_vars_hash:WP_Query:private] => 142cd08274a5c5faff512379bc31bff8

[query_vars_changed:WP_Query:private] => 1

[thumbnails_cached] =>

[allow_query_attachment_by_filename:protected] =>

[stopwords:WP_Query:private] =>

[compat_fields:WP_Query:private] => Array

(

[0] => query_vars_hash

[1] => query_vars_changed

)

[compat_methods:WP_Query:private] => Array

(

[0] => init_query_flags

[1] => parse_tax_query

)

[query_cache_key:WP_Query:private] => wp_query:fd2e3db9653ba968f04925ce42ebe132:0.40265700 17541208230.83941300 1754120823

[tribe_is_event] =>

[tribe_is_multi_posttype] =>

[tribe_is_event_category] =>

[tribe_is_event_venue] =>

[tribe_is_event_organizer] =>

[tribe_is_event_query] =>

[tribe_is_past] =>

[tribe_controller] => Tribe\Events\Views\V2\Query\Event_Query_Controller Object

(

[filtering_query:Tribe\Events\Views\V2\Query\Event_Query_Controller:private] => WP_Query Object

*RECURSION*

)

)

[post_title] => Agile, sprints en ‘done’ in de rechtszaal: Waarom rechters IT-deskundigen nodig hebben

[post_excerpt] =>

[post_status] => publish

[comment_status] => open

[ping_status] => open

[post_password] =>

[post_name] => agile-sprints-en-done-in-de-rechtszaal-waarom-rechters-it-deskundigen-nodig-hebben

[to_ping] =>

[pinged] =>

[post_modified] => 2025-08-01 15:34:12

[post_modified_gmt] => 2025-08-01 13:34:12

[post_content_filtered] =>

[post_parent] => 0

[guid] => https://bg.legal/?p=45384

[menu_order] => 0

[post_type] => post

[post_mime_type] =>

[comment_count] => 0

[filter] => raw

)

[comment_count] => 0

[current_comment] => -1

[found_posts] => 268

[max_num_pages] => 27

[max_num_comment_pages] => 0

[is_single] =>

[is_preview] =>

[is_page] =>

[is_archive] => 1

[is_date] =>

[is_year] =>

[is_month] =>

[is_day] =>

[is_time] =>

[is_author] =>

[is_category] =>

[is_tag] =>

[is_tax] => 1

[is_search] =>

[is_feed] =>

[is_comment_feed] =>

[is_trackback] =>

[is_home] =>

[is_privacy_policy] =>

[is_404] =>

[is_embed] =>

[is_paged] =>

[is_admin] =>

[is_attachment] =>

[is_singular] =>

[is_robots] =>

[is_favicon] =>

[is_posts_page] =>

[is_post_type_archive] =>

[query_vars_hash:WP_Query:private] => 142cd08274a5c5faff512379bc31bff8

[query_vars_changed:WP_Query:private] => 1

[thumbnails_cached] =>

[allow_query_attachment_by_filename:protected] =>

[stopwords:WP_Query:private] =>

[compat_fields:WP_Query:private] => Array

(

[0] => query_vars_hash

[1] => query_vars_changed

)

[compat_methods:WP_Query:private] => Array

(

[0] => init_query_flags

[1] => parse_tax_query

)

[query_cache_key:WP_Query:private] => wp_query:fd2e3db9653ba968f04925ce42ebe132:0.40265700 17541208230.83941300 1754120823

[tribe_is_event] =>

[tribe_is_multi_posttype] =>

[tribe_is_event_category] =>

[tribe_is_event_venue] =>

[tribe_is_event_organizer] =>

[tribe_is_event_query] =>

[tribe_is_past] =>

[tribe_controller] => Tribe\Events\Views\V2\Query\Event_Query_Controller Object

(

[filtering_query:Tribe\Events\Views\V2\Query\Event_Query_Controller:private] => WP_Query Object

*RECURSION*

)

)

18 nov 2024

21 aug 2024